编程的基础知识中,理解字节及其在编码中的作用至关重要。本文将深入探讨字节的概念、不同编码方式以及其在计算机编程中的应用。

字节是计算机存储单位的基本构建块,通常由8个比特(bit)组成。一个字节可以表示256(2^8)个不同的值,范围从0到255。在计算机科学中,字节用于存储单个字符或数据单元。

ASCII(American Standard Code for Information Interchange)是最早的字符编码标准,使用7位字节(8位字节的低7位),共有128个字符,包括英文字母、数字和特殊符号。

Unicode是一种字符集,旨在为世界上每种语言的每个字符提供唯一的数字代码。UTF8、UTF16和UTF32是Unicode的不同编码方式,其中UTF8是最常用的一种。

除了ASCII和Unicode,还有一些其他的字符编码方式,如ISO8859系列、GB2312等,它们主要用于特定语言或地区的字符集。

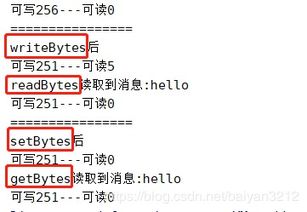

在编程中,文件通常被视为字节序列的集合。读取和写入文件时,程序将数据转换为字节流进行处理。

在网络通信中,数据以字节流的形式在计算机之间传输。网络协议通常规定了数据的传输格式和编码方式。

字符串在计算机中被表示为字符序列,而字符则被编码为字节序列。在字符串操作中,需要注意字符编码的转换和处理。

字节是计算机编程中的基础知识,理解字节及其在编码中的作用对于开发高效、可靠的软件至关重要。通过深入学习字节的概念、不同的编码方式以及在编程中的应用,可以提升编程技能,更好地处理数据和字符编码。

文章已关闭评论!

2024-11-26 16:51:21

2024-11-26 16:50:13

2024-11-26 16:49:08

2024-11-26 16:47:52

2024-11-26 16:46:48

2024-11-26 16:45:36

2024-11-26 16:44:11

2024-11-26 16:42:54